Dienstag, 28. Juni 2011

Freitag, 24. Juni 2011

Globale Abkühlung zu erwarten

Die Sonne ist der entscheidende Klimafaktor, siehe dazu auch: Die Sonne bestimmt das Klima. Der Sonnenwind bestimmt, wieviel der galaktischen Strahlung auf der Erde eintrifft und dort zur Wolkenbildung beiträgt, die ihrerseits das Rückstrahlvermögen des Planeten beeinflusst. Dieser sonst unsichtbare Teil der Sonnenaktivität wird durch das Polarlicht sichtbar, das entsteht, wenn elektrisch geladene Teilchen des Sonnenwindes auf die Erdatmosphäre treffen und dort die Luftmoleküle zum Leuchten anregen. Das folgende Bild zeigt ein Nordlicht über Bear Lake, Alaska, am 18. Januar 2005 (Quelle: US Air Force, Joshua Strang):

Diese Lichterscheinungen sind an beiden magnetischen Polen zu sehen, d. h. nördlich 60° nördlicher Breite und südlich 60° südlicher Breite. Auf dem nächsten Bild sieht man ein Südlicht über der Antarktis, aufgenommen am 22.04.2006 durch Samuel Blanc (Quelle: Image Editor):

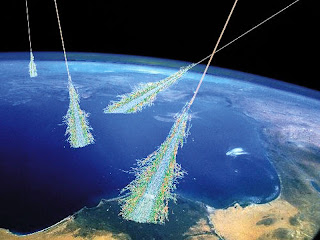

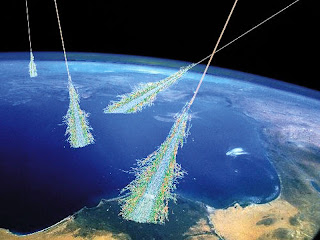

Dänischen Wissenschaftlern ist es nun gelungen, weitere Beweise für den Einfluss der Sonne auf das Klima zu sammeln, siehe dazu die Pressemitteilung Scientists at Aarhus University (AU) and the National Space Institute (DTU Space) show that particles from space create cloud cover. Es konnte in einem Experiment gezeigt werden, dass die galaktische Strahlung in der Erdatmosphäre zur Bildung von Aerosolpartikeln führt, die Kondensationskerne für die Wassertropfen darstellen, aus denen die niedrigen Wolken bestehen. Die folgende Zeichnung zeigt das Auftreffen energiereicher galaktischer Strahlen auf die Atmosphäre und die dadurch ausgelöste Erzeugung von Kaskaden neuer Partikel, darunter auch energiereicher Elektronen, die in der Lage sind, die Kondensationskerne von Wolken zu bilden (Bild: NASA Images):

Die folgende Grafik zeigt die Wirkung der galaktischen Strahlung auf die Wolkenbildung (Quelle: Technical University of Denmark, National Space Institute):

Der Einfluss der Sonnenaktivität auf die Wolkenbildung lässt sich empirisch belegen. Durch Neutronenzählungen an verschiedenen Stationen, z. B. in Oulu (Finnland) seit 1960, weiß man, dass es ein inverses Verhältnis zwischen Sonnenzyklus und der auf der Erdoberfläche eintreffenden galaktischen Strahlung gibt: im Maximum des Sonnenzyklus wird das Minimum der galaktischen Strahlung erreicht. Ein Sonnenzyklus ist normalerweise 11 Jahre lang, er kann aber auch 9 bis 16 Jahren dauern. Es gibt eine Korrelation zwischen der Länge des Sonnenzyklus und seiner Amplitude: je kürzer der Zyklus, desto höher die Amplitude. Ein hoher Ausschlag bedeutet viele Sonnenflecken und einen starken Sonnenwind, der die Erde stärker von der galaktischen Strahlung abschirmt. Das folgende Bild verdeutlicht die Größenordnungen, indem es einen Sonnenflecken maßstabsgetreu zur Erde in Beziehung setzt (Quelle: Institute for Solar Physics der Schwedischen Akademie der Wissenschaften (Sonnenfleck) und NASA Apollo 17 (Erde). Das Foto des Sonnenflecken wurde im Mai 2010 mit dem Swedish 1-m Solar Telescope des Observatoriums auf La Palma, Kanarische Inseln, aufgenommen):

Friis-Christensen und Lassen fanden eine Korrelation zwischen der Länge des Sonnenzyklus und den globalen Temperaturen (Friis-Christensen, E. and Lassen, K., 1991. Length of the solar cycle: An indicator of solar activity closely associated with climate, Science, 254:698-7001991). An einigen der wenigen Temperaturmessreihen, die sich über einen langen Zeitraum erstrecken, konnte diese Beziehung ebenfalls nachgewiesen werden, so z. B. für Armagh in Nordirland durch Butler und Johnson (Butler, C. J. und Johnston, D. J., 1996. A provisional long mean air temperature series for Armagh Observatory, Journal of Atmospheric Terrestrial Physics, 58:1657-1672), für De Bilt, Niederlande, durch Archibald (Archibald, D., 2006. Solar Cycles 24 and 25 and predicted climate response, Energy and Environment, 17:29-38) und für Temperaturdaten aus dem Nordosten der USA ebenfalls durch Archibald (Archibald, D., 2009. Solar cycle 24: Expectation and implications. Energy and Environment, 20:1-11). In diesen Untersuchungen wurde eine starke Korrelation von 0,7° C pro Jahr der Abweichung des Sonnenzyklus von der Dauer seines Vorgängers festgestellt.

Der letzte Sonnenzyklus, in der Zählung der Solarphysiker die Nummer 23, war bereits deutlich schwächer als seine Vorgänger. Er endete im Mai 2009 und erreichte damit eine Dauer von 13 Jahren. Dadurch wurde er 3,4 Jahre älter als der Sonnenzyklus 22. Der oben erwähnte Zusammenhang zwischen Zykluslänge und Temperatur lässt in den mittleren Breiten eine Abkühlung von circa 2,2° C während der Dauer des gegenwärtigen Sonnenzyklus 24 erwarten. Die thermische Trägheit der Ozeane verlangsamt die Abkühlung, kann sie aber nicht verhindern.

Die American Astronomical Society hat am 14. Juni auf dem jährlichen Treffen ihrer Solar Physics Division bekannt gegeben, dass die Ergebnisse von drei unabhängigen Zweigen ihrer Solarforschung auf eine drastische Abschwächung des gegenwärtigen und des nächsten Sonnenzyklus hinweisen, siehe dazu: All three of these lines of research to point to the familiar sunspot cycle shutting down for a while. Es wurde festgestellt, dass der Strahlstrom im Sonneninneren stark nachgelassen hat, die Sonnenflecken auf der sichtbaren Oberfläche der Sonne abnehmen und schwächer werden, und auch die Sonnencorona und -pole Veränderungen in diese Richtung aufweisen, siehe dazu: Sun’s Fading Spots Signal Big Drop in Solar Activity.

Wir wollen hier zumindest auf eine der Studien näher eingehen, von denen in der Mitteilung der AAS die Rede war. Matt Penn, William Livingston und Leif Svalgaard berichten in ihrer Arbeit A Decade of Diminishing Sunspot Vigor von den Ergebnissen ihrer Solarforschung mit dem McMath-Pierce Telescope auf dem Kitt Peak in Arizona. Sie erwarten einen langfristigen Trend zur Abschwächung der Sonnenfleckenstärke und sagen voraus, dass im kommenden Sonnenzyklus 25 kaum oder überhaupt keine Sonnenflecken gebildet werden. Die folgende Grafik zeigt, dass die durchschnittliche Magnetfeldstärke der Sonnenflecken in den Sonnenzyklen 22, 23 und 24 ständig abgenommen hat und hierdurch die magnetische Grenze näher rückt, unter der keine Sonnenflecken mehr entstehen können (Quelle: Penn u. a.):

Die Solar Physics Division der AAS hat in ihrer Pressemitteilung WHAT’S DOWN WITH THE SUN? MAJOR DROP IN SOLAR ACTIVITY PREDICTED erklärt: "A missing jet stream, fading spots, and slower activity near the poles say that our Sun is heading for a rest period ..." Frank Hill, der stellvertretende Direktor des Solar Synoptic Network des National Solar Observatory sagte: "This is highly unusual and unexpected, but the fact that three completely different views of the Sun point in the same direction is a powerful indicator that the sunspot cycle may be going into hibernation." Hill zog aus der bisherigen Forschung den Schluss: "If we are right, this could be the last solar maximum we’ll see for a few decades. That would affect everything from space exploration to Earth’s climate."

Die abnehmende Sonnenaktivität lässt eine globale Abkühlung erwarten, die jener der Jahre zwischen 1645 und 1715 gleicht, als sich die Sonne im Maunderminimum befand, während dem keine Sonnenflecken beobachtet wurden. Diese Periode war der kälteste Zeitraum der Kleinen Eiszeit, in dem sehr kalte und lange Winter sowie kühle Sommer auf der Erde vorherrschten.

Diese Lichterscheinungen sind an beiden magnetischen Polen zu sehen, d. h. nördlich 60° nördlicher Breite und südlich 60° südlicher Breite. Auf dem nächsten Bild sieht man ein Südlicht über der Antarktis, aufgenommen am 22.04.2006 durch Samuel Blanc (Quelle: Image Editor):

Dänischen Wissenschaftlern ist es nun gelungen, weitere Beweise für den Einfluss der Sonne auf das Klima zu sammeln, siehe dazu die Pressemitteilung Scientists at Aarhus University (AU) and the National Space Institute (DTU Space) show that particles from space create cloud cover. Es konnte in einem Experiment gezeigt werden, dass die galaktische Strahlung in der Erdatmosphäre zur Bildung von Aerosolpartikeln führt, die Kondensationskerne für die Wassertropfen darstellen, aus denen die niedrigen Wolken bestehen. Die folgende Zeichnung zeigt das Auftreffen energiereicher galaktischer Strahlen auf die Atmosphäre und die dadurch ausgelöste Erzeugung von Kaskaden neuer Partikel, darunter auch energiereicher Elektronen, die in der Lage sind, die Kondensationskerne von Wolken zu bilden (Bild: NASA Images):

Die folgende Grafik zeigt die Wirkung der galaktischen Strahlung auf die Wolkenbildung (Quelle: Technical University of Denmark, National Space Institute):

Der Einfluss der Sonnenaktivität auf die Wolkenbildung lässt sich empirisch belegen. Durch Neutronenzählungen an verschiedenen Stationen, z. B. in Oulu (Finnland) seit 1960, weiß man, dass es ein inverses Verhältnis zwischen Sonnenzyklus und der auf der Erdoberfläche eintreffenden galaktischen Strahlung gibt: im Maximum des Sonnenzyklus wird das Minimum der galaktischen Strahlung erreicht. Ein Sonnenzyklus ist normalerweise 11 Jahre lang, er kann aber auch 9 bis 16 Jahren dauern. Es gibt eine Korrelation zwischen der Länge des Sonnenzyklus und seiner Amplitude: je kürzer der Zyklus, desto höher die Amplitude. Ein hoher Ausschlag bedeutet viele Sonnenflecken und einen starken Sonnenwind, der die Erde stärker von der galaktischen Strahlung abschirmt. Das folgende Bild verdeutlicht die Größenordnungen, indem es einen Sonnenflecken maßstabsgetreu zur Erde in Beziehung setzt (Quelle: Institute for Solar Physics der Schwedischen Akademie der Wissenschaften (Sonnenfleck) und NASA Apollo 17 (Erde). Das Foto des Sonnenflecken wurde im Mai 2010 mit dem Swedish 1-m Solar Telescope des Observatoriums auf La Palma, Kanarische Inseln, aufgenommen):

Friis-Christensen und Lassen fanden eine Korrelation zwischen der Länge des Sonnenzyklus und den globalen Temperaturen (Friis-Christensen, E. and Lassen, K., 1991. Length of the solar cycle: An indicator of solar activity closely associated with climate, Science, 254:698-7001991). An einigen der wenigen Temperaturmessreihen, die sich über einen langen Zeitraum erstrecken, konnte diese Beziehung ebenfalls nachgewiesen werden, so z. B. für Armagh in Nordirland durch Butler und Johnson (Butler, C. J. und Johnston, D. J., 1996. A provisional long mean air temperature series for Armagh Observatory, Journal of Atmospheric Terrestrial Physics, 58:1657-1672), für De Bilt, Niederlande, durch Archibald (Archibald, D., 2006. Solar Cycles 24 and 25 and predicted climate response, Energy and Environment, 17:29-38) und für Temperaturdaten aus dem Nordosten der USA ebenfalls durch Archibald (Archibald, D., 2009. Solar cycle 24: Expectation and implications. Energy and Environment, 20:1-11). In diesen Untersuchungen wurde eine starke Korrelation von 0,7° C pro Jahr der Abweichung des Sonnenzyklus von der Dauer seines Vorgängers festgestellt.

Der letzte Sonnenzyklus, in der Zählung der Solarphysiker die Nummer 23, war bereits deutlich schwächer als seine Vorgänger. Er endete im Mai 2009 und erreichte damit eine Dauer von 13 Jahren. Dadurch wurde er 3,4 Jahre älter als der Sonnenzyklus 22. Der oben erwähnte Zusammenhang zwischen Zykluslänge und Temperatur lässt in den mittleren Breiten eine Abkühlung von circa 2,2° C während der Dauer des gegenwärtigen Sonnenzyklus 24 erwarten. Die thermische Trägheit der Ozeane verlangsamt die Abkühlung, kann sie aber nicht verhindern.

Die American Astronomical Society hat am 14. Juni auf dem jährlichen Treffen ihrer Solar Physics Division bekannt gegeben, dass die Ergebnisse von drei unabhängigen Zweigen ihrer Solarforschung auf eine drastische Abschwächung des gegenwärtigen und des nächsten Sonnenzyklus hinweisen, siehe dazu: All three of these lines of research to point to the familiar sunspot cycle shutting down for a while. Es wurde festgestellt, dass der Strahlstrom im Sonneninneren stark nachgelassen hat, die Sonnenflecken auf der sichtbaren Oberfläche der Sonne abnehmen und schwächer werden, und auch die Sonnencorona und -pole Veränderungen in diese Richtung aufweisen, siehe dazu: Sun’s Fading Spots Signal Big Drop in Solar Activity.

Wir wollen hier zumindest auf eine der Studien näher eingehen, von denen in der Mitteilung der AAS die Rede war. Matt Penn, William Livingston und Leif Svalgaard berichten in ihrer Arbeit A Decade of Diminishing Sunspot Vigor von den Ergebnissen ihrer Solarforschung mit dem McMath-Pierce Telescope auf dem Kitt Peak in Arizona. Sie erwarten einen langfristigen Trend zur Abschwächung der Sonnenfleckenstärke und sagen voraus, dass im kommenden Sonnenzyklus 25 kaum oder überhaupt keine Sonnenflecken gebildet werden. Die folgende Grafik zeigt, dass die durchschnittliche Magnetfeldstärke der Sonnenflecken in den Sonnenzyklen 22, 23 und 24 ständig abgenommen hat und hierdurch die magnetische Grenze näher rückt, unter der keine Sonnenflecken mehr entstehen können (Quelle: Penn u. a.):

Die Solar Physics Division der AAS hat in ihrer Pressemitteilung WHAT’S DOWN WITH THE SUN? MAJOR DROP IN SOLAR ACTIVITY PREDICTED erklärt: "A missing jet stream, fading spots, and slower activity near the poles say that our Sun is heading for a rest period ..." Frank Hill, der stellvertretende Direktor des Solar Synoptic Network des National Solar Observatory sagte: "This is highly unusual and unexpected, but the fact that three completely different views of the Sun point in the same direction is a powerful indicator that the sunspot cycle may be going into hibernation." Hill zog aus der bisherigen Forschung den Schluss: "If we are right, this could be the last solar maximum we’ll see for a few decades. That would affect everything from space exploration to Earth’s climate."

Die abnehmende Sonnenaktivität lässt eine globale Abkühlung erwarten, die jener der Jahre zwischen 1645 und 1715 gleicht, als sich die Sonne im Maunderminimum befand, während dem keine Sonnenflecken beobachtet wurden. Diese Periode war der kälteste Zeitraum der Kleinen Eiszeit, in dem sehr kalte und lange Winter sowie kühle Sommer auf der Erde vorherrschten.

Donnerstag, 16. Juni 2011

Die Geochemie von CO2

Das IPCC nimmt an, dass das atmosphärische CO2 in der jüngsten Erdgeschichte immer konstant war, bis dann ab 1750 die Menschheit in der industriellen Revolution begann, größere Mengen fossiler Energieträger zu verbrennen. Das daraus stammende Kohlendioxid akkumuliere sich seither in der Atmosphäre, denn es habe dort eine sehr lange Verweildauer. In seinem 4. Assessment Report von 2007 macht das IPCC dazu keine genauen Angaben, sondern spricht nur von einer "rough indication 50 - 200 years". Andere Vertreter der Theorie einer katastrophalen anthropogenen globalen Erwärmung nehmen eine Verweildauer von mehr als tausend Jahren an, so z. B. Solomon, S.; Plattner, G.K.; Knutti, R.; Friedlingstein, P. Irreversible climate change due to carbon dioxide emissions. Proc. Natl. Acad. Sci. USA 2009, 106, 1704-1709.

Diese Annahmen stehen in Widerspruch zu einer Vielzahl von empirischen Untersuchungen, in denen mit den verschiedensten Methoden eine Verweildauer des Kohlendioxids in der Atmosphäre von circa 5 - 6 Jahren festgestellt wurde. Die folgende Grafik gibt einen Überblick über den bisherigen Forschungsstand (Tom Segalstad, Geochemistry of CO2: The Whereabouts of CO2 on Earth, presented at the Fourth International Conference on Climate Change, Chicago, IL, USA, 18. Mai 2010):

Das in der Atmosphäre befindliche Kohlendioxid stammt aus unterschiedlichen Quellen, die sich anhand ihrer spezifischen Kohlenstoff-Isotope identifizieren lassen. Pflanzen bevorzugen das leichtere 12C Isotop, während z. B. CO2 aus Vulkanen reicher an 13C ist. Deshalb lässt das Verhältnis 13C/12C die Herkunft des atmosphärischen Kohlendioxid erkennen. Die in der obigen Grafik erwähnten empirischen Messungen der Kohlenstoff-Isotope haben ergeben, dass maximal 4% des Kohlendioxids in der Atmosphäre aus anthropogenen Emissionen stammen, während 96% anderen Ursprungs, wie z.B. ozeanischer oder vulkanischer Herkunft sind. Da die Aufenthaltsdauer von CO2 in der Atmosphäre nur etwa 5 Jahre beträgt, ist seine jährliche Austauschmenge von 134 Gt (18% des atmosphärischen CO2 von insgesamt 748 Gt) viel größer als vom IPCC angenommen. Im Vergleich dazu ist die jährliche Emission von 7 Gt Kohlendioxid aus der Verbrennung fossiler Energieträger unbedeutend. Daraus ergibt sich, dass der Beitrag der menschengemachten CO2-Emissionen zur globalen Treibhauswirkung sehr gering ist, wie die nächste Grafik zeigt (Tom Segalstad, op. cit.):

Der Treibhauseffekt beträgt insgesamt 146 W/m2. Dazu trägt der Mensch durch die Nutzung fossiler Brennstoffe 0,4 W/m2 bei, das ist ein Anteil von 0,27% am Energieeintrag und von weniger als 0,1% am dadurch bewirkten Temperaturanstieg. Diese Zahlen sind das Ergebnis einer Vielzahl empirischer Studien, die alle in einem fundamentalen Widerspruch zu den Behauptungen des IPCC stehen. Es gibt keine wissenschaftliche Rechtfertigung der Klimapolitik. Weitere Informationen zu dem Thema finden sich auf der Website des Geochemikers Tom Segalstad.

Diese Annahmen stehen in Widerspruch zu einer Vielzahl von empirischen Untersuchungen, in denen mit den verschiedensten Methoden eine Verweildauer des Kohlendioxids in der Atmosphäre von circa 5 - 6 Jahren festgestellt wurde. Die folgende Grafik gibt einen Überblick über den bisherigen Forschungsstand (Tom Segalstad, Geochemistry of CO2: The Whereabouts of CO2 on Earth, presented at the Fourth International Conference on Climate Change, Chicago, IL, USA, 18. Mai 2010):

Das in der Atmosphäre befindliche Kohlendioxid stammt aus unterschiedlichen Quellen, die sich anhand ihrer spezifischen Kohlenstoff-Isotope identifizieren lassen. Pflanzen bevorzugen das leichtere 12C Isotop, während z. B. CO2 aus Vulkanen reicher an 13C ist. Deshalb lässt das Verhältnis 13C/12C die Herkunft des atmosphärischen Kohlendioxid erkennen. Die in der obigen Grafik erwähnten empirischen Messungen der Kohlenstoff-Isotope haben ergeben, dass maximal 4% des Kohlendioxids in der Atmosphäre aus anthropogenen Emissionen stammen, während 96% anderen Ursprungs, wie z.B. ozeanischer oder vulkanischer Herkunft sind. Da die Aufenthaltsdauer von CO2 in der Atmosphäre nur etwa 5 Jahre beträgt, ist seine jährliche Austauschmenge von 134 Gt (18% des atmosphärischen CO2 von insgesamt 748 Gt) viel größer als vom IPCC angenommen. Im Vergleich dazu ist die jährliche Emission von 7 Gt Kohlendioxid aus der Verbrennung fossiler Energieträger unbedeutend. Daraus ergibt sich, dass der Beitrag der menschengemachten CO2-Emissionen zur globalen Treibhauswirkung sehr gering ist, wie die nächste Grafik zeigt (Tom Segalstad, op. cit.):

Der Treibhauseffekt beträgt insgesamt 146 W/m2. Dazu trägt der Mensch durch die Nutzung fossiler Brennstoffe 0,4 W/m2 bei, das ist ein Anteil von 0,27% am Energieeintrag und von weniger als 0,1% am dadurch bewirkten Temperaturanstieg. Diese Zahlen sind das Ergebnis einer Vielzahl empirischer Studien, die alle in einem fundamentalen Widerspruch zu den Behauptungen des IPCC stehen. Es gibt keine wissenschaftliche Rechtfertigung der Klimapolitik. Weitere Informationen zu dem Thema finden sich auf der Website des Geochemikers Tom Segalstad.

Donnerstag, 9. Juni 2011

Energiewende in den Abgrund

Die Bundesregierung hat im September 2010 ihr Energieprogramm vorgelegt, das folgende Ziele enthält:

Der letzte der obigen Punkte sollte den Wahnsinn des staatlichen Energiekonzepts etwas mildern, aber die am 14.12.2010 in Kraft getretene Verlängerung der KKW-Laufzeiten wurde bereits drei Monate später durch das Kernkraftmoratorium und die darauf folgende Stilllegung von sieben Kernkraftwerken wieder aufgehoben. Heute hat die Bundesregierung ein Gesetz in den Bundestag eingebracht, nach dem im Laufe der nächsten 11 Jahre alle KKW für immer abzuschalten sind. Diese Energiepolitik werde, so versichert sie, eine "umweltschonende, zuverlässige und bezahlbare Energieversorgung" sicherstellen. Wir wollen diesen Anspruch hier näher überprüfen.

Ersetzt man die bisherige Stromerzeugung aus deutschen Kernkraftwerken je zur Hälfte durch Importe und durch Strom aus inländischen Kohle- und Gaskraftwerken, dann würden im Jahre 2018 dadurch von der deutschen Energiewirtschaft 62 Millionen Tonnen CO2 mehr emittiert als bei Beibehaltung der bestehenden KKW, was einer Zunahme um 28% entspricht (Wissenschaftliche Analyse zu schnellem Kernenergieausstieg des BDI vom 24.04.2011). Allein in den 3 Monaten des Atommoratoriums vom März 2011 bis heute wurden in Deutschland rund 8 Millionen Tonnen CO2 zusätzlich erzeugt. Damit verstößt die politische Klasse gegen ihre eigenen Reduktionsziele. Die regenerativen Energien sind alles andere als umweltfreundlich:

Nach der Zwangsabschaltung der sieben KKW im März kam es nur deshalb nicht zu Stromausfällen im deutschen Netz, weil die EVU in Spitzenzeiten alle Kohle- und Gaskraftwerke bis zur Maximalleistung hochfahren und vorerst die schon geplanten Wartungs- und Instandhaltungsarbeiten verschoben haben. Auch die Netzbetreiber verzichten auf diese Arbeiten in ihren Höchstspannungsnetzen, weil sogar kurzfristige Abschaltungen in der gegenwärtigen Mangelsituation flächendeckende Stromausfälle sehr wahrscheinlich machen. Siehe dazu: E.On fährt Gas- und Kohlekraftwerke hoch.

Im kommenden Winter sind an kalten, windarmen Tagen, wenn unsere Nachbarn ihren Strom selber brauchen, weiträumige Netzzusammenbrüche zu erwarten. Auf jeden Fall wird Deutschland als Stütze für das europäische Netz ausfallen und statt dessen seine schwache Stelle werden, die andere Netzteilnehmer ständig bedroht.

Der ständig fluktuierende Wind- und Solarstrom ist mit einem stabilen Hochleistungsnetz nicht vereinbar. Großtechnische Speichermöglichkeiten zur Lösung dieses Problems sind beim gegenwärtigen Stand der Technik nur die Pumpspeicherwerke, für die es in Deutschland kaum weitere Ausbaumöglichkeiten gibt. Das Pumpspeicherwerk Atdorf im Schwarzwald wird vermutlich der letzte große Speicherbau dieser Art sein, denn grüne Bürgerinitiativen bekämpfen erbittert jedes neue Projekt.

Die Seekabel-Verbindung durch die Nordsee zu den norwegischen Wasserkraftwerken wird keine spürbare Entlastung bringen, denn die milliardenteure 530 km lange Leitung kann nur 1.400 MW übertragen. Das entspricht gerade einmal 4% der schon jetzt in Deutschland installierten Windstromleistung. Außerdem sind die meisten norwegischen Wasserkraftwerke keine Speicherwerke, die Wasser bergauf pumpen könnten. Sie müßten mit großem Aufwand umgebaut werden, falls ihre norwegischen Betreibern das überhaupt wollen.

Die grüne Behauptung, dass in Zukunft Millionen von Elektroautos mit ihren Batterien das Speicherproblem des Wind- und Solarstroms lösen würden, ist unglaubwürdig. Es wird in den nächsten Jahrzehnten keine nennenswerte Anzahl von Elektroautos geben, da noch sehr lange keine bezahlbaren, für den Winterbetrieb geeigneten und mit ausreichender Energiekapazität ausgestatteten Batterien gebaut werden können. Die Hoffnung auf einen technologischen Durchbruch in diesem Bereich ist reine Illusion.

Eine weitere Fehleinschätzung liegt in der Annahme, dass die Eigentümer von Elektroautos bereit wären, die Batterien ihrer Fahrzeuge den Stromversorgern zum Ausgleich ihrer Einspeisungsschwankungen zu überlassen. Die Lebensdauer der teuren Batterie wird nicht durch ihr Alter, sondern allein durch die Anzahl der Lade-Entlade-Vorgänge bestimmt. Wenn die Autobatterie nach Bedarf der EVU geladen und entladen wird, senkt das ihre Lebensdauer erheblich. Einer derartigen Zweckentfremdung würde ihr Eigentümer nur zustimmen, wenn er von den Stromversorgern eine Nutzungsgebühr erheben könnte. Das wiederum führte zu einer drastischen Verteuerung dieser Speichermöglichkeit, für die auch noch eine gigantische Infrastruktur aufzubauen wäre.

Von illusionärem Wunschdenken geprägt sind auch alle Vorschläge, den Windstrom für eine elektrolytische Spaltung von Wasser zu nutzen und den daraus gewonnenen Wasserstoff wieder in Strom zurückzuverwandeln. Das wären äußerst kostspielige Energievernichtungsanlagen mit Energieverlusten im Bereich von 70% bis 80%, siehe dazu: Wasserstoff ist kein Ersatz für Erdöl.

Der durch die KKW-Abschaltungen plötzlich notwendig gewordene zusätzliche Stromimport brachte die Börsenstrompreise zum Steigen, übrigens auch für unsere Nachbarstaaten. So erhöhten sich seit dem Kernenergieausstieg die Preise an den Strombörsen um 12% und die Kurse der Emissionszertifikate um 10%.

Seit der Abschaltung der sieben KKW am 17. März 2011 importiert Deutschland zusätzlich täglich circa 45 Millionen KWh. Dafür zahlen die deutschen Abnehmer einen Preis, der um rund 50 Euro pro MWh über dem Abgabepreis der stillgelegten deutschen Kernkraftwerke liegt. Allein das bedeutet für die Stromverbraucher seit dem Abschalttag eine tägliche Mehrbelastung von rund 2,3 Millionen Euro.

Nach einer Studie des BDI lässt die stufenweise Abschaltung der Kernkraftwerke die Strompreise bis 2018 um ein Drittel steigen. "Bis 2020 kämen auf die Stromverbraucher allein durch einen vorgezogenen Kernenergieausstieg Mehrkosten von insgesamt rund 33 Milliarden Euro zu. Die steigenden Preise erklären sich vor allem durch den Einsatz teurerer Erzeugungstechnologien und durch höhere CO2-Preise. Den größten Anteil müssten Industrie und weitere Gewerbekunden übernehmen: Sie hätten in diesem Zeitraum 24 Milliarden Euro Mehrkosten zu tragen, private Verbraucher neun Milliarden Euro. Rechnet man die Mehrkosten eines Ausstiegs mit den absehbaren Kosten des Ausbaus erneuerbarer Energien und der Netzinfrastruktur gemäß Energiekonzept für alle Kunden zusammen, so betragen die Mehrbelastungen bis 2020 sogar 51 Milliarden Euro." (Wissenschaftliche Analyse zu schnellem Kernenergieausstieg)

Jeder Bürger kann berechnen wieviel ihm die politische Bevorzugung der regenerativen Energien kostet, indem er die Vergütungssätze für Wind-, Solar- und Biomassestrom (Einspeisevergütung gem. EEG) mit den Gestehungskosten (ohne Steuern, Abgaben, Verteilungskosten, Gewinn) für Strom aus Kohle-, Gas- und Kernkraftwerken vergleicht. Die Gestehungskosten für die konventionelle Stromerzeugung betragen (Panos Konstantin, Praxisbuch Energiewirtschaft):

Die Einspeisevergütungen für Ökostrom gem. Erneuerbare-Energien-Gesetz (EEG) betragen im Jahre 2011 (Wikipedia, Erneuerbare-Energien-Gesetz):

Hierzu kommen die Kosten des Netzausbaus, um den Ökostrom zu den Verbrauchszentren zu bringen. In den nächsten zehn Jahren sind 4.500 km neue Höchstspannungsleitungen zu bauen, um die regenerative Stromerzeugung von 17% auf 40% zu steigern. Auf der Mittel- und Niederspannungsebene sind zusätzliche Leitungen von 200.000 bis 400.000 km erforderlich. Allein schon die Kosten des politisch erzwungenen Um- und Ausbaus der Stromnetze werden die Strompreise deutlich erhöhen.

Durch den Kernenergieausstieg verliert Deutschland die Fähigkeit zum Bau neuer Kernkraftwerke und damit viele potentielle Kunden, die sich diese Hochtechnologie zunutze machen wollen. Das bedeutet den Verlust anspruchsvoller Arbeitsplätze, die Abwanderung Hochqualifizierter ins Ausland und eine steigende Abhängigkeit von immer teuer werdenden Stromimporten. Die Kernkraftwerke der 4. Generation, in denen es aus physikalischen Gründen zu keiner Kernschmelze kommen kann, sind inhärent sicher, siehe dazu The Generation IV International Forum. Sie werden aber nicht mehr von deutschen Unternehmen gebaut werden, die damit in diesem entscheidenden Bereich zur Bedeutungslosigkeit absinken.

- Verminderung der Treibhausgasemissionen gegenüber dem Wert des Jahres 1990 um 40% bis zum Jahre 2020 und um 80% bis 95% bis 2050.

- Reduktion des Primärenergieverbrauchs bis 2020 um 20% und bis 2050 um 50% gegenüber dem Stand des Jahres 2008.

- Steigerung des Anteils der erneuerbaren Energien am Bruttoendenergieverbrauch auf 18% und am Bruttostromverbrauch auf 35% bis 2020. Für 2050 sollen das 60% bzw. 80% sein.

- Laufzeitverlängerung für die Kernkraftwerke um durchschnittlich 12 Jahre.

Der letzte der obigen Punkte sollte den Wahnsinn des staatlichen Energiekonzepts etwas mildern, aber die am 14.12.2010 in Kraft getretene Verlängerung der KKW-Laufzeiten wurde bereits drei Monate später durch das Kernkraftmoratorium und die darauf folgende Stilllegung von sieben Kernkraftwerken wieder aufgehoben. Heute hat die Bundesregierung ein Gesetz in den Bundestag eingebracht, nach dem im Laufe der nächsten 11 Jahre alle KKW für immer abzuschalten sind. Diese Energiepolitik werde, so versichert sie, eine "umweltschonende, zuverlässige und bezahlbare Energieversorgung" sicherstellen. Wir wollen diesen Anspruch hier näher überprüfen.

Umweltschonend

Ersetzt man die bisherige Stromerzeugung aus deutschen Kernkraftwerken je zur Hälfte durch Importe und durch Strom aus inländischen Kohle- und Gaskraftwerken, dann würden im Jahre 2018 dadurch von der deutschen Energiewirtschaft 62 Millionen Tonnen CO2 mehr emittiert als bei Beibehaltung der bestehenden KKW, was einer Zunahme um 28% entspricht (Wissenschaftliche Analyse zu schnellem Kernenergieausstieg des BDI vom 24.04.2011). Allein in den 3 Monaten des Atommoratoriums vom März 2011 bis heute wurden in Deutschland rund 8 Millionen Tonnen CO2 zusätzlich erzeugt. Damit verstößt die politische Klasse gegen ihre eigenen Reduktionsziele. Die regenerativen Energien sind alles andere als umweltfreundlich:

- Energetische Biomassenutzung. Diese Verbrennung von Lebensmitteln verursacht steigende Lebensmittelpreise, Hunger in Entwicklungsländern (siehe dazu: Sündenböcke in Ägypten und Tunesien), Abholzung von Tropenwäldern für den Anbau von Ölpalmen, riesigen Flächenverbrauch, Monokulturen mit Verarmung der Böden, immensen Düngemitteleinsatz und Wasserverbrauch. Das selbst gesetzte Ziel einer Reduktion der Kohlendioxidemissionen wird nicht nur nicht erreicht, sondern die CO2-Bilanz ist sogar negativ.

- Windstrom. Die Behauptung, dass durch die Nutzung der Windkraft fossile Brennstoffe eingespart würden und dem entsprechend die Emission von Kohlendioxid vermindert werden könnte, ist falsch. Modellrechnungen zeigen, dass durch die vom EEG erzwungene bevorzugte Einspeisung des Windstroms mehr fossile Energie verbraucht wird, als dies ohne den Einsatz der Windenergie notwendig wäre. Die EVU müssen konventionelle Kraftwerkskapazitäten in der Höhe der installierten Windstromnennleistung als Puffer bereit halten, um die Schwankungen der Windstromeinspeisung auszugleichen, wobei die mit fossilen Brennstoffen befeuerten Reserveanlagen ständig herauf- oder herunterzufahren sind, was nur mit erheblichen Effizienzeinbußen möglich ist, da die Backup-Kraftwerke hierbei außerhalb ihres Optimums betrieben werden. Dadurch ist ihr Brennstoffverbrauch höher als im Normalbetrieb, was oft die Brennstoffeinsparung der Windkraftanlagen überkompensiert, siehe dazu: Windige Geschäfte.

- Solarstrom. Auch für die Solarenergie gilt grundsätzlich, dass die behauptete Brennstoffeinsparung in der Praxis nicht erreicht wird, siehe dazu: Solarenergie verbrennt Geld.

Zuverlässig

Nach der Zwangsabschaltung der sieben KKW im März kam es nur deshalb nicht zu Stromausfällen im deutschen Netz, weil die EVU in Spitzenzeiten alle Kohle- und Gaskraftwerke bis zur Maximalleistung hochfahren und vorerst die schon geplanten Wartungs- und Instandhaltungsarbeiten verschoben haben. Auch die Netzbetreiber verzichten auf diese Arbeiten in ihren Höchstspannungsnetzen, weil sogar kurzfristige Abschaltungen in der gegenwärtigen Mangelsituation flächendeckende Stromausfälle sehr wahrscheinlich machen. Siehe dazu: E.On fährt Gas- und Kohlekraftwerke hoch.

Im kommenden Winter sind an kalten, windarmen Tagen, wenn unsere Nachbarn ihren Strom selber brauchen, weiträumige Netzzusammenbrüche zu erwarten. Auf jeden Fall wird Deutschland als Stütze für das europäische Netz ausfallen und statt dessen seine schwache Stelle werden, die andere Netzteilnehmer ständig bedroht.

Der ständig fluktuierende Wind- und Solarstrom ist mit einem stabilen Hochleistungsnetz nicht vereinbar. Großtechnische Speichermöglichkeiten zur Lösung dieses Problems sind beim gegenwärtigen Stand der Technik nur die Pumpspeicherwerke, für die es in Deutschland kaum weitere Ausbaumöglichkeiten gibt. Das Pumpspeicherwerk Atdorf im Schwarzwald wird vermutlich der letzte große Speicherbau dieser Art sein, denn grüne Bürgerinitiativen bekämpfen erbittert jedes neue Projekt.

Die Seekabel-Verbindung durch die Nordsee zu den norwegischen Wasserkraftwerken wird keine spürbare Entlastung bringen, denn die milliardenteure 530 km lange Leitung kann nur 1.400 MW übertragen. Das entspricht gerade einmal 4% der schon jetzt in Deutschland installierten Windstromleistung. Außerdem sind die meisten norwegischen Wasserkraftwerke keine Speicherwerke, die Wasser bergauf pumpen könnten. Sie müßten mit großem Aufwand umgebaut werden, falls ihre norwegischen Betreibern das überhaupt wollen.

Die grüne Behauptung, dass in Zukunft Millionen von Elektroautos mit ihren Batterien das Speicherproblem des Wind- und Solarstroms lösen würden, ist unglaubwürdig. Es wird in den nächsten Jahrzehnten keine nennenswerte Anzahl von Elektroautos geben, da noch sehr lange keine bezahlbaren, für den Winterbetrieb geeigneten und mit ausreichender Energiekapazität ausgestatteten Batterien gebaut werden können. Die Hoffnung auf einen technologischen Durchbruch in diesem Bereich ist reine Illusion.

Eine weitere Fehleinschätzung liegt in der Annahme, dass die Eigentümer von Elektroautos bereit wären, die Batterien ihrer Fahrzeuge den Stromversorgern zum Ausgleich ihrer Einspeisungsschwankungen zu überlassen. Die Lebensdauer der teuren Batterie wird nicht durch ihr Alter, sondern allein durch die Anzahl der Lade-Entlade-Vorgänge bestimmt. Wenn die Autobatterie nach Bedarf der EVU geladen und entladen wird, senkt das ihre Lebensdauer erheblich. Einer derartigen Zweckentfremdung würde ihr Eigentümer nur zustimmen, wenn er von den Stromversorgern eine Nutzungsgebühr erheben könnte. Das wiederum führte zu einer drastischen Verteuerung dieser Speichermöglichkeit, für die auch noch eine gigantische Infrastruktur aufzubauen wäre.

Von illusionärem Wunschdenken geprägt sind auch alle Vorschläge, den Windstrom für eine elektrolytische Spaltung von Wasser zu nutzen und den daraus gewonnenen Wasserstoff wieder in Strom zurückzuverwandeln. Das wären äußerst kostspielige Energievernichtungsanlagen mit Energieverlusten im Bereich von 70% bis 80%, siehe dazu: Wasserstoff ist kein Ersatz für Erdöl.

Bezahlbar

Der durch die KKW-Abschaltungen plötzlich notwendig gewordene zusätzliche Stromimport brachte die Börsenstrompreise zum Steigen, übrigens auch für unsere Nachbarstaaten. So erhöhten sich seit dem Kernenergieausstieg die Preise an den Strombörsen um 12% und die Kurse der Emissionszertifikate um 10%.

Seit der Abschaltung der sieben KKW am 17. März 2011 importiert Deutschland zusätzlich täglich circa 45 Millionen KWh. Dafür zahlen die deutschen Abnehmer einen Preis, der um rund 50 Euro pro MWh über dem Abgabepreis der stillgelegten deutschen Kernkraftwerke liegt. Allein das bedeutet für die Stromverbraucher seit dem Abschalttag eine tägliche Mehrbelastung von rund 2,3 Millionen Euro.

Nach einer Studie des BDI lässt die stufenweise Abschaltung der Kernkraftwerke die Strompreise bis 2018 um ein Drittel steigen. "Bis 2020 kämen auf die Stromverbraucher allein durch einen vorgezogenen Kernenergieausstieg Mehrkosten von insgesamt rund 33 Milliarden Euro zu. Die steigenden Preise erklären sich vor allem durch den Einsatz teurerer Erzeugungstechnologien und durch höhere CO2-Preise. Den größten Anteil müssten Industrie und weitere Gewerbekunden übernehmen: Sie hätten in diesem Zeitraum 24 Milliarden Euro Mehrkosten zu tragen, private Verbraucher neun Milliarden Euro. Rechnet man die Mehrkosten eines Ausstiegs mit den absehbaren Kosten des Ausbaus erneuerbarer Energien und der Netzinfrastruktur gemäß Energiekonzept für alle Kunden zusammen, so betragen die Mehrbelastungen bis 2020 sogar 51 Milliarden Euro." (Wissenschaftliche Analyse zu schnellem Kernenergieausstieg)

Jeder Bürger kann berechnen wieviel ihm die politische Bevorzugung der regenerativen Energien kostet, indem er die Vergütungssätze für Wind-, Solar- und Biomassestrom (Einspeisevergütung gem. EEG) mit den Gestehungskosten (ohne Steuern, Abgaben, Verteilungskosten, Gewinn) für Strom aus Kohle-, Gas- und Kernkraftwerken vergleicht. Die Gestehungskosten für die konventionelle Stromerzeugung betragen (Panos Konstantin, Praxisbuch Energiewirtschaft):

- Braunkohlekraftwerke: 4,6 Cent/KWh.

- Steinkohlekraftwerke: 4,9 Cent/KWh.

- Kernkraftwerk (abg.): 2,2 Cent/KWh.

- Kernkraftwerk-Neubau: 5,0 Cent/KWh.

- Gas-Dampf-Kraftwerke: 5,7 Cent/KWh.

Die Einspeisevergütungen für Ökostrom gem. Erneuerbare-Energien-Gesetz (EEG) betragen im Jahre 2011 (Wikipedia, Erneuerbare-Energien-Gesetz):

- Windstrom Landanlage: 9,2 Cent/KWh.

- Windstrom Offshore: 13,0 Cent/KWh.

- Biomassestrom Grundvergütung: 11,67 Cent/KWh bis 150 KW, danach absinkend bis 7,79 Cent/KWh bei 5 MW - 20 MW, dazu zahlreiche Boni wie Nawaro-Bonus, Gülle-Bonus, Technologie-Bonus, Kraft-Wärme-Kopplungs-Bonus und Formaldehyd-Bonus.

- Photovoltaikstrom: 28,74 Cent/KWh bis 24,43 Cent/KWh je nach Zeitpunkt der Inbetriebnahme.

Hierzu kommen die Kosten des Netzausbaus, um den Ökostrom zu den Verbrauchszentren zu bringen. In den nächsten zehn Jahren sind 4.500 km neue Höchstspannungsleitungen zu bauen, um die regenerative Stromerzeugung von 17% auf 40% zu steigern. Auf der Mittel- und Niederspannungsebene sind zusätzliche Leitungen von 200.000 bis 400.000 km erforderlich. Allein schon die Kosten des politisch erzwungenen Um- und Ausbaus der Stromnetze werden die Strompreise deutlich erhöhen.

Durch den Kernenergieausstieg verliert Deutschland die Fähigkeit zum Bau neuer Kernkraftwerke und damit viele potentielle Kunden, die sich diese Hochtechnologie zunutze machen wollen. Das bedeutet den Verlust anspruchsvoller Arbeitsplätze, die Abwanderung Hochqualifizierter ins Ausland und eine steigende Abhängigkeit von immer teuer werdenden Stromimporten. Die Kernkraftwerke der 4. Generation, in denen es aus physikalischen Gründen zu keiner Kernschmelze kommen kann, sind inhärent sicher, siehe dazu The Generation IV International Forum. Sie werden aber nicht mehr von deutschen Unternehmen gebaut werden, die damit in diesem entscheidenden Bereich zur Bedeutungslosigkeit absinken.

Montag, 6. Juni 2011

Donnerstag, 2. Juni 2011

Natürliche Klimaschwankungen

Die Anhänger der Theorie der katastrophalen anthropogenen globalen Erwärmung (KAGE) behaupten, dass die seit dem 19. Jahrhundert in Schüben stattfindende Erwärmung einmalig in der Erdgeschichte sei. Ein Blick auf die Klimageschichte der gegenwärtigen Zwischeneiszeit zeigt, dass das nicht der Fall ist (Quelle: David Archibald, Solar Cycle 24: Implications for the United States):

Während des Klimaoptimums des Holozän lagen die Temperaturen um mehrere Grad Celsius über den heutigen Werten. Dem entsprechend verlief während der drei Jahrtausende des Klimaoptimums die Baumgrenze in den Alpen 200 bis 300 m höher, in Sibirien und Nordamerika 300 km weiter nördlich als heute. Der Meeresspiegel war zu jener Zeit 2 m höher als in der Gegenwart. "Since the Holocene Optimum about eight thousand years ago, we have been in long term temperature decline at about 0.25 degrees per thousand years." (David Archibald, op. cit.) Die jüngste globale Erwärmung ist also in unserer Zwischeneiszeit nichts Außergewöhnliches.

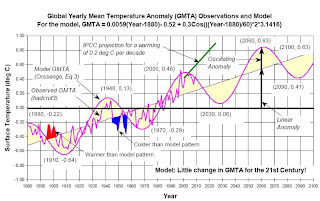

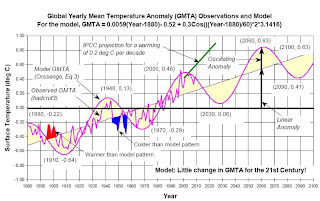

Die nächste Grafik zeigt die globalen Temperaturen seit 1880 und versucht eine Trendextrapolation bis zum Jahre 2100 (Quelle: Girma Orssengo, Predictions Of Global Mean Temperatures & IPCC Projections):

Wir sehen, dass die globale Temperaturentwicklung in Erwärmungs- und Abkühlungsphasen von jeweils 30 Jahren verläuft. In den 120 Jahren vor der Jahrtausendwende gab es zwei Abkühlungsperioden, eine von 1880 bis 1910 und die andere von 1940 bis 1970; sowie zwei Erwärmungsperioden, eine von 1910 bis 1940 und die andere von 1970 bis 2000. Während des gesamten Zeitraums nahm aber die Konzentration von CO2 in der Atmosphäre ständig zu. Es gibt deshalb für die Hälfte des Beobachtungszeitraums keine Korrelation zwischen diesem Treibhausgas und dem Temperaturverlauf. Die beiden Abkühlungsphasen widerlegen die herrschende Klimalehre. "...comparison of observed increase in human emission of CO2 with increase in GMTA [Global Mean Temperature Anomaly] during the 20th century shows no relationship between the two. As a result, the claim by the IPCC of climate catastrophe is not supported by the data." (Girma Orssengo, op. cit.) Der Trend zu langfristig steigenden Temperaturen besteht seit dem Dalton Minimum der Kleinen Eiszeit und hat deshalb nichts mit den viel später einsetzenden technischen Kohlendioxidemissionen zu tun, sondern ist Teil eines langfristigen natürlichen Klimazyklus.

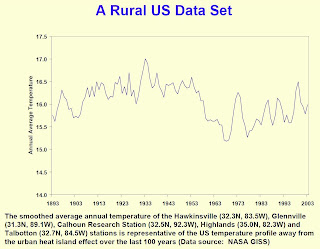

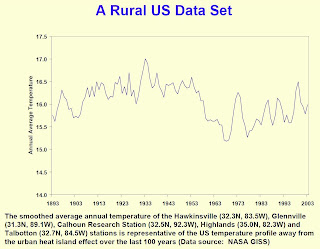

Die obige Grafik beruht auf der Auswertung der Daten von Bodenmessstationen, deren Mehrheit durch falsche Standortwahl dem städtischen Hitzeinseleffekt ausgesetzt ist und deshalb systematisch zu hohe Temperaturen angibt. Es lohnt sich daher, die Messungen von Stationen im ländlichen Raum, die vom städtischen Hitzeinseleffekt nicht beeinflusst sind, mit den urbanen Messreihen zu vergleichen. Die folgende Grafik zeigt die Werte von fünf Messstellen in den ländlichen USA von 1893 bis 2003 (Quelle: David Archibald, op. cit.):

Die außerstädtischen Messwerte aus den USA zeigen, dass es zumindest dort zu Beginn des 21. Jahrhunderts kühler war als in den 1930er-Jahren. "The 1.5° temperature decline from the late 1950s to the mid-70s was due to a weak solar cycle 20 after a strong solar cycle 19." (David Archibald, op. cit.) Diese Entwicklung ist weltweit zu beobachten. So war es in Grönland vor achtzig Jahren deutlich wärmer als heute. Der angeblich dominante Klimafaktor Kohlendioxid scheint nur sehr selektiv zu wirken.

"In fact, there is increasing evidence that much of the increase in ground temperature measurements during the 1980s and early 1990s may be more the result of the urban heat island effect, the poor placement of measuring instruments, and even attempts by the compilers of temperature data to manipulate the ground-based station data than it is of actual temperature increases." (Alan Carlin, A Multidisciplinary, Science-Based Approach to the Economics of Climate Change, International Journal of Environmental Research and Public Health, 2011, 8, 985-1031; doi:10.3390/ijerph8040985) Eine Fülle von Beweisen für diese Vermutung liefern Joseph D’Aleo und Anthony Watts in ihrem Artikel Surface Temperature Records: Policy-Driven Deception?, wo sie feststellen:

Sehen wir uns die Satellitendaten an, die seit 1978 zur Verfügung stehen (Quelle: Arno Arrak, Satellite Data Show No Warming Before 1997. Changes Since Not Related to CO2, zitiert nach Alan Carlin, op. cit.):

Die Grafik zeigt die wirklich weltweiten Temperaturmessungen in der unteren Troposphäre durch die Satelliten, die von der University of Alabama in Huntsville (UAH) und dem Unternehmen Remote Sensing Systems (RSS) betreut werden. Gemessen wird mit einer Microwave Sounding Unit (MSU). Es fällt auf, dass die von den Satelliten gemessenen Temperaturschwankungen mit den periodischen Oszillationen im Pazifik, El Niño (Erwärmung) and La Niña (Abkühlung) genannt, übereinstimmen. Die gelben Punkte in der Grafik bezeichnen die Mitte zwischen diesen ozeanischen Ereignissen. Man sieht, dass von 1978 bis 1997 die Durchschnittstemperatur konstant geblieben ist.

"The record shows global climate oscillations with a period of three to five years and a peak-to-peak amplitude of 0.4 to 0.5 degrees Celsius about a common, fixed mean temperature that lasted from 1978 to 1997. Since this mean temperature did not change for twenty years the late twentieth century warming touted by IPCC and others simply did not happen. The cause of these newly discovered climate oscillations is large-scale periodic movement of ocean waters from shore to shore, part of the El Niño - Southern Oscillation (ENSO) system." (Arno Arrak, op. cit.) Die globalen Zirkulationsmodelle des IPCC berücksichtigen weder die ENSO noch andere periodische ozeanische Oszillationen und sind deshalb nicht in der Lage, das gegenwärtige Wetter zu erklären oder das künftige vorherzusagen.

Der außergewöhnlich starke El Niño von 1998 kann nicht durch das atmosphärische Kohlendioxid erklärt werden. Danach blieben die Temperaturen in der unteren Troposphäre auf einem etwas höheren Niveau konstant, obwohl in diesem Zeitraum die CO2-Konzentration zunahm. "Carbon dioxide cannot explain the lack of warming in the eighties and nineties, nor any of the abrupt warmings that followed, nor the stasis of the twenty first century high, nor the temperature downturn that followed it in 2007 and bottomed out in 2008." (Arno Arrak, op. cit.) Wohin man auch blickt, in den Temperaturdaten ist keine Spur der Treibhausgase zu finden.

Während des Klimaoptimums des Holozän lagen die Temperaturen um mehrere Grad Celsius über den heutigen Werten. Dem entsprechend verlief während der drei Jahrtausende des Klimaoptimums die Baumgrenze in den Alpen 200 bis 300 m höher, in Sibirien und Nordamerika 300 km weiter nördlich als heute. Der Meeresspiegel war zu jener Zeit 2 m höher als in der Gegenwart. "Since the Holocene Optimum about eight thousand years ago, we have been in long term temperature decline at about 0.25 degrees per thousand years." (David Archibald, op. cit.) Die jüngste globale Erwärmung ist also in unserer Zwischeneiszeit nichts Außergewöhnliches.

Die nächste Grafik zeigt die globalen Temperaturen seit 1880 und versucht eine Trendextrapolation bis zum Jahre 2100 (Quelle: Girma Orssengo, Predictions Of Global Mean Temperatures & IPCC Projections):

Wir sehen, dass die globale Temperaturentwicklung in Erwärmungs- und Abkühlungsphasen von jeweils 30 Jahren verläuft. In den 120 Jahren vor der Jahrtausendwende gab es zwei Abkühlungsperioden, eine von 1880 bis 1910 und die andere von 1940 bis 1970; sowie zwei Erwärmungsperioden, eine von 1910 bis 1940 und die andere von 1970 bis 2000. Während des gesamten Zeitraums nahm aber die Konzentration von CO2 in der Atmosphäre ständig zu. Es gibt deshalb für die Hälfte des Beobachtungszeitraums keine Korrelation zwischen diesem Treibhausgas und dem Temperaturverlauf. Die beiden Abkühlungsphasen widerlegen die herrschende Klimalehre. "...comparison of observed increase in human emission of CO2 with increase in GMTA [Global Mean Temperature Anomaly] during the 20th century shows no relationship between the two. As a result, the claim by the IPCC of climate catastrophe is not supported by the data." (Girma Orssengo, op. cit.) Der Trend zu langfristig steigenden Temperaturen besteht seit dem Dalton Minimum der Kleinen Eiszeit und hat deshalb nichts mit den viel später einsetzenden technischen Kohlendioxidemissionen zu tun, sondern ist Teil eines langfristigen natürlichen Klimazyklus.

Die obige Grafik beruht auf der Auswertung der Daten von Bodenmessstationen, deren Mehrheit durch falsche Standortwahl dem städtischen Hitzeinseleffekt ausgesetzt ist und deshalb systematisch zu hohe Temperaturen angibt. Es lohnt sich daher, die Messungen von Stationen im ländlichen Raum, die vom städtischen Hitzeinseleffekt nicht beeinflusst sind, mit den urbanen Messreihen zu vergleichen. Die folgende Grafik zeigt die Werte von fünf Messstellen in den ländlichen USA von 1893 bis 2003 (Quelle: David Archibald, op. cit.):

Die außerstädtischen Messwerte aus den USA zeigen, dass es zumindest dort zu Beginn des 21. Jahrhunderts kühler war als in den 1930er-Jahren. "The 1.5° temperature decline from the late 1950s to the mid-70s was due to a weak solar cycle 20 after a strong solar cycle 19." (David Archibald, op. cit.) Diese Entwicklung ist weltweit zu beobachten. So war es in Grönland vor achtzig Jahren deutlich wärmer als heute. Der angeblich dominante Klimafaktor Kohlendioxid scheint nur sehr selektiv zu wirken.

"In fact, there is increasing evidence that much of the increase in ground temperature measurements during the 1980s and early 1990s may be more the result of the urban heat island effect, the poor placement of measuring instruments, and even attempts by the compilers of temperature data to manipulate the ground-based station data than it is of actual temperature increases." (Alan Carlin, A Multidisciplinary, Science-Based Approach to the Economics of Climate Change, International Journal of Environmental Research and Public Health, 2011, 8, 985-1031; doi:10.3390/ijerph8040985) Eine Fülle von Beweisen für diese Vermutung liefern Joseph D’Aleo und Anthony Watts in ihrem Artikel Surface Temperature Records: Policy-Driven Deception?, wo sie feststellen:

- "Instrumental temperature data for the pre-satellite era (1850-1980) have been so widely, systematically, and uni-directionally tampered with that it cannot be credibly asserted there has been any significant 'global warming' in the 20th century.

- All terrestrial surface-temperature databases exhibit signs of urban heat pollution and post measurement adjustments that render them unreliable for determining accurate long-term temperature trends.

- All of the problems have skewed the data so as greatly to overstate observed warming both regionally and globally.

- Global terrestrial temperature data are compromised because more than three-quarters of the 6,000 stations that once reported are no longer being used in data trend analyses.

- There has been a significant increase in the number of missing months with 40% of the GHCN [Global Historical Climatology Network] stations reporting at least one missing month. This requires infilling which adds to the uncertainty and possible error.

- Contamination by urbanization, changes in land use, improper siting, and inadequately-calibrated instrument upgrades further increases uncertainty.

- Numerous peer-reviewed papers in recent years have shown the overstatement of observed longer term warming is 30-50% from heat-island and land use change contamination.

- An increase in the percentage of compromised stations with interpolation to vacant data grids may make the warming bias greater than 50% of 20th-century warming.

- In the oceans, data are missing and uncertainties are substantial. Changes in data sets introduced a step warming in 2009.

- Satellite temperature monitoring has provided an alternative to terrestrial stations in compiling the global lower-troposphere temperature record. Their findings are increasingly diverging from the station-based constructions in a manner consistent with evidence of a warm bias in the surface temperature record."

Sehen wir uns die Satellitendaten an, die seit 1978 zur Verfügung stehen (Quelle: Arno Arrak, Satellite Data Show No Warming Before 1997. Changes Since Not Related to CO2, zitiert nach Alan Carlin, op. cit.):

Die Grafik zeigt die wirklich weltweiten Temperaturmessungen in der unteren Troposphäre durch die Satelliten, die von der University of Alabama in Huntsville (UAH) und dem Unternehmen Remote Sensing Systems (RSS) betreut werden. Gemessen wird mit einer Microwave Sounding Unit (MSU). Es fällt auf, dass die von den Satelliten gemessenen Temperaturschwankungen mit den periodischen Oszillationen im Pazifik, El Niño (Erwärmung) and La Niña (Abkühlung) genannt, übereinstimmen. Die gelben Punkte in der Grafik bezeichnen die Mitte zwischen diesen ozeanischen Ereignissen. Man sieht, dass von 1978 bis 1997 die Durchschnittstemperatur konstant geblieben ist.

"The record shows global climate oscillations with a period of three to five years and a peak-to-peak amplitude of 0.4 to 0.5 degrees Celsius about a common, fixed mean temperature that lasted from 1978 to 1997. Since this mean temperature did not change for twenty years the late twentieth century warming touted by IPCC and others simply did not happen. The cause of these newly discovered climate oscillations is large-scale periodic movement of ocean waters from shore to shore, part of the El Niño - Southern Oscillation (ENSO) system." (Arno Arrak, op. cit.) Die globalen Zirkulationsmodelle des IPCC berücksichtigen weder die ENSO noch andere periodische ozeanische Oszillationen und sind deshalb nicht in der Lage, das gegenwärtige Wetter zu erklären oder das künftige vorherzusagen.

Der außergewöhnlich starke El Niño von 1998 kann nicht durch das atmosphärische Kohlendioxid erklärt werden. Danach blieben die Temperaturen in der unteren Troposphäre auf einem etwas höheren Niveau konstant, obwohl in diesem Zeitraum die CO2-Konzentration zunahm. "Carbon dioxide cannot explain the lack of warming in the eighties and nineties, nor any of the abrupt warmings that followed, nor the stasis of the twenty first century high, nor the temperature downturn that followed it in 2007 and bottomed out in 2008." (Arno Arrak, op. cit.) Wohin man auch blickt, in den Temperaturdaten ist keine Spur der Treibhausgase zu finden.

Abonnieren

Posts (Atom)